-

Ruby 官网改版了,新的设计还蛮好看的 at 2025年12月21日

牌面

牌面 -

RubyGems 的组织管理引发争议 🍉 at 2025年10月18日

Matz 出马了,看来这波连续剧完结了。

-

SolidQueue 支持防抖式的 Job 么? at 2025年10月16日

不是数据库还真不好去做这个查询

吊打也说不上吧,只要合理控制对应队列的大小,这种查询对队列后端的压力都不大的。

-

Building, Deploying, and Monitoring Ruby Web Applications with Falcon (Kaigi on Rails 2025) at 2025年10月16日

不然并发能力只有几个就太难受了。

这是指使用 SSE 实现实时传输时的并发能力吗?对应的服务器配置是?

-

SolidQueue 支持防抖式的 Job 么? at 2025年10月16日

还有一个思路,不要盯着新的 Job,而是在执行 PopulateGlobalPostsCacheJob 时,利用队列的 API,检查是否有新的 PopulateGlobalPostsCacheJob 在排队,有的话就跳过当前 Job,不再执行。

-

SolidQueue 支持防抖式的 Job 么? at 2025年10月16日

我想到的办法就是在模型的 after_commit 中,插入一个在 2 分钟后执行的异步任务。如果这时发现有等待中的任务,就取消之前的这个任务。

如果 PopulateGlobalPostsCacheJob 的语义符合要求(执行结果只和执行时间相关,和 Job enqueue 时间无关),这种场景 discard 新的异步任务,让等待中的任务正常执行,结果是相同的。

-

SolidQueue 支持防抖式的 Job 么? at 2025年10月14日

没用过,但是扫了一眼文档

https://github.com/rails/solid_queue?tab=readme-ov-file#concurrency-controls

这里的 on_conflict 似乎能支持这个用法

-

SSL 挂啦来源了,监控网站的 SSL 证书,及时提醒通知更新 at 2025年09月27日

SSL 挂啦

SSL 挂啦 -

我和代码的三十年:皱纹会增多,但价值不会减少 at 2025年09月26日

AI 味太浓了,打回重写。

-

好消息:RubyMine 现在对非商业用途免费 at 2025年09月12日

建议 WSL + VScode remote

-

Turbo Stream Broadcast - 被低估的 Rails 功能 at 2025年08月16日

我一开始也是想着用 append 的方案来避免重复发送内容,但是因为要显示后端渲染成 HTML 的 markdown,无奈改成用 update 了。

只 append markdown 给前端,然后在前端处理 markdown 渲染应该能够解决这个问题,不过当时时间有限,就没有进一步处理。

-

Turbo Stream Broadcast - 被低估的 Rails 功能 at 2025年08月12日

跟风发一个用 Turbo Stream 实现的流式更新 LLM 返回的消息的练手项目(其实是某不靠谱猎头机构的面试题,通过后发现目标职位根本不存在)。

https://github.com/coderliu/ai-meeting-digest

和 Rei 不同的是,我这个用了比较原始的 broadcast_action_to

-

ransack 在使用的时候,可能需要注意 distinct 的影响 at 2025年04月26日

感谢分享,这一点之前还真的没注意过,都是无脑 distinct: true

-

Ruby 编辑器 at 2025年03月21日

RubyMine 涨价前买了三年,今年到期后不打算续了。

VSCode + Ruby LSP 体验已经很不错了,最近开始尝试使用 Windsurf。

-

[远程] Tasktag 招聘 Ruby on Rails 中、高级工程师,北美项目,可远程办公 at 2024年11月15日

顶一下,这两年论坛里的远程岗位越来越少了,主贴提供一下薪资范围就更好了

-

前后端分离,哪一端处理用户密码加密问题? at 2024年07月25日

首先 MD5 是摘要算法,不叫加密

-

解决了 Writebook 产品的中文输入问题 at 2024年07月19日

好奇是什么原因导致的这个中文支持的问题

-

rails 7.0.6 遇到事务中执行 return,会 rollback 的情况 at 2023年10月22日

可怕是 master 分支又改回去了

-

ruby 学习环境搭建(wsl+ubuntu+ruby+rubymine+debug) at 2022年08月26日

感谢楼主的贴子让我一时兴起从 VSCode Remote + Virtualbox 虚拟机的方案切到了 WSL2 + RubyMine。

-

[已招满][远程办公][上海][北京][深圳][杭州][南京] 欧洲铁路公司招聘高级 Ruby 开发工程师 at 2022年07月02日

这个公司名用 Ruby on Rails 真的太合理了

-

ActionText 让人头大!(===== 已解决 =====) at 2022年02月17日

目测最后查下来都和 ActionText 没关系

-

【全职远程】外企高薪招聘 Ruby 工程师 at 2021年11月11日

Cookpad?

-

使用 MySQL 持久化数据时没有同步的问题 at 2021年09月14日

能拿到 ID 应该是持久化成功了,save 时的 validation 应该是通过了,感觉 replica 同步延迟的可能性大一些

-

[武汉] 巧议网络 - Elixir 后端工程师(长期招聘) at 2021年09月14日

之前是在上海吧?这是开分矿了?

-

推荐一个 Rails 网站作品 at 2021年08月27日

这 3 位知道自己"说了"这些话吗?说真的,这种做法太 low 了

-

Ruby 的方法查找再往前一步 at 2021年07月30日

白天在群里看到楼主的讨论,发现自己也不是太清楚这个细节,晚上 Google 搜到的下面的文章 https://medium.com/@leo_hetsch/demystifying-singleton-classes-in-ruby-caf3fa4c9d91 看完之后再看楼主这篇帖子,感觉理解得差不多了。

-

又踩了个 open-uri 的坑,老库的 API 有时候真是摸不着头脑 at 2021年07月14日

原来 open 在请求小文件的时候返回 StringIO 对象。。。这个特性我都没有找到对应的文档

这个坑我也踩过

-

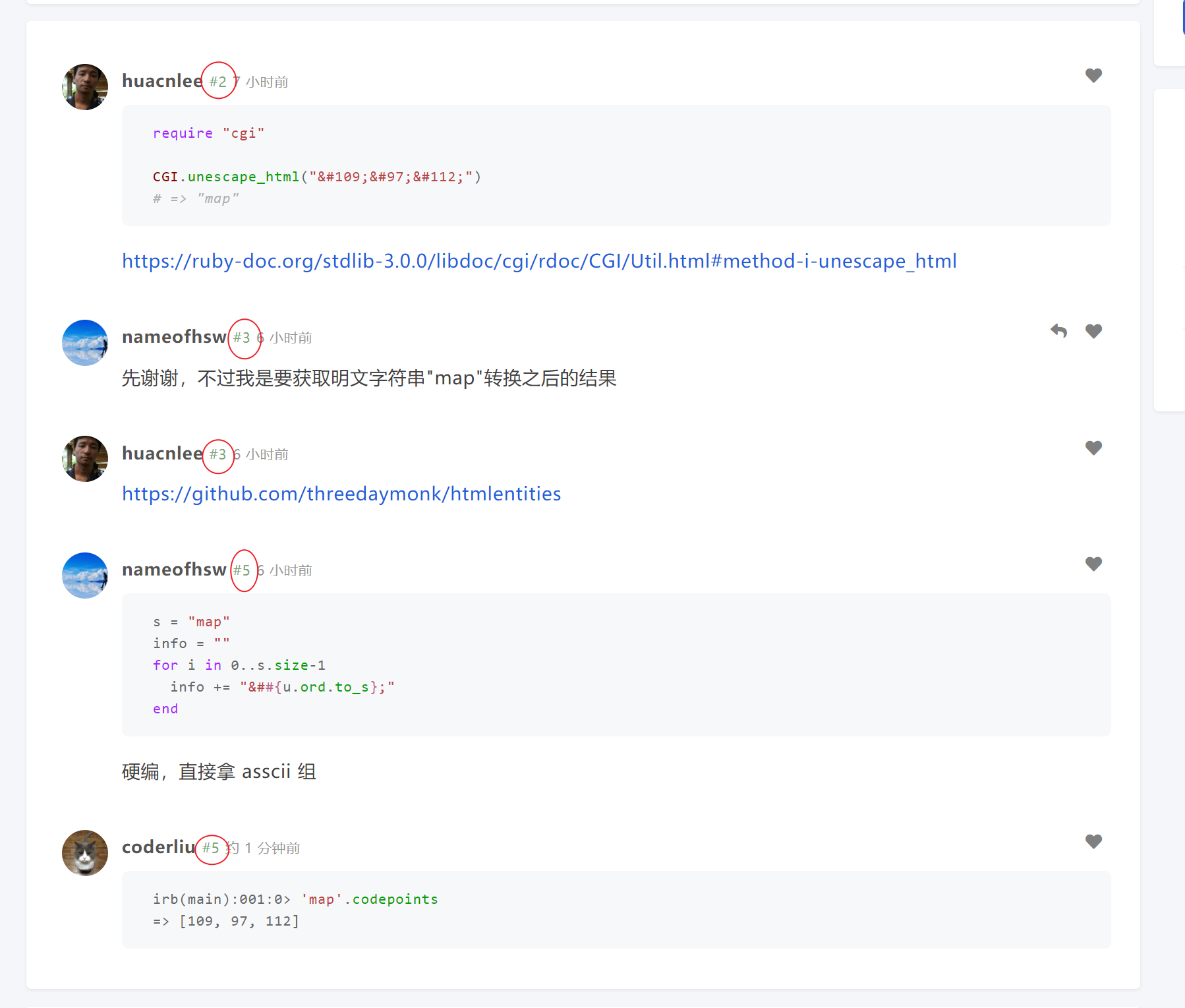

怎么实现 unicode 编码,比如想要获取字符串"map"对应的编码内容"map" at 2021年05月31日

@huacnlee 楼层数不太对

@huacnlee 楼层数不太对